搭建环境

# 安装Ollama

开源免费的大模型运行工具,支持所有主流开源模型

- https://ollama.com/download (opens new window)下载Windows版本安装包

- 双击安装包,等待安装完成(整个过程10秒左右)

- 验证安装是否成功: 按下Win+R键,输入cmd打开命令提示符 输入:ollama --version,如果出现版本信息,说明安装成功

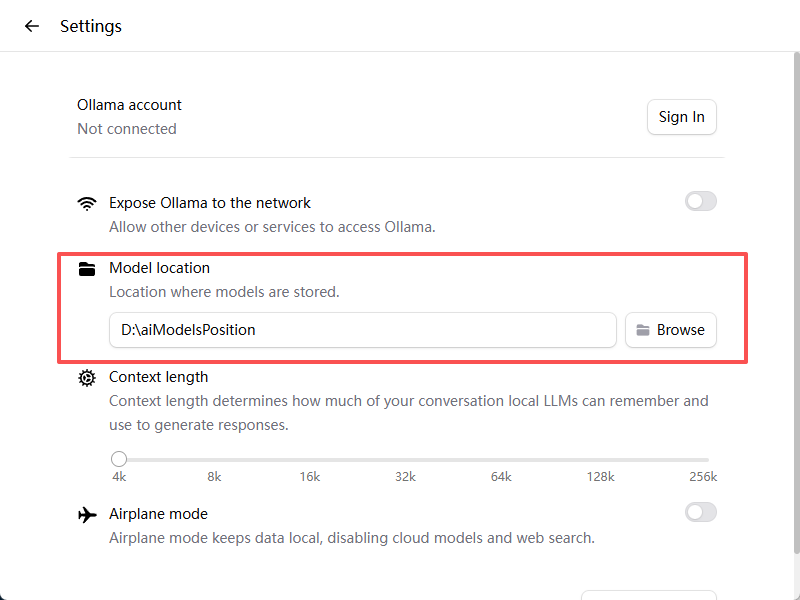

- 打开Ollama,修改模型存储的位置,防止模型存在C盘

- 在LM Studio搜索框输入qwen3:8b,点击下载

::: tips

首选模型:Qwen3-8B 为什么选它?

中文理解能力顶尖,对产品配置文档、中文术语支持最佳

80亿参数,性能足够应对日常知识库查询需求

完全开源免费,支持商用,没有任何限制备选模型:DeepSeek-R1 适用场景: 技术类文档、代码、配置公式处理能力更强 对于复杂逻辑推理和多步骤问题解答更有优势 :::

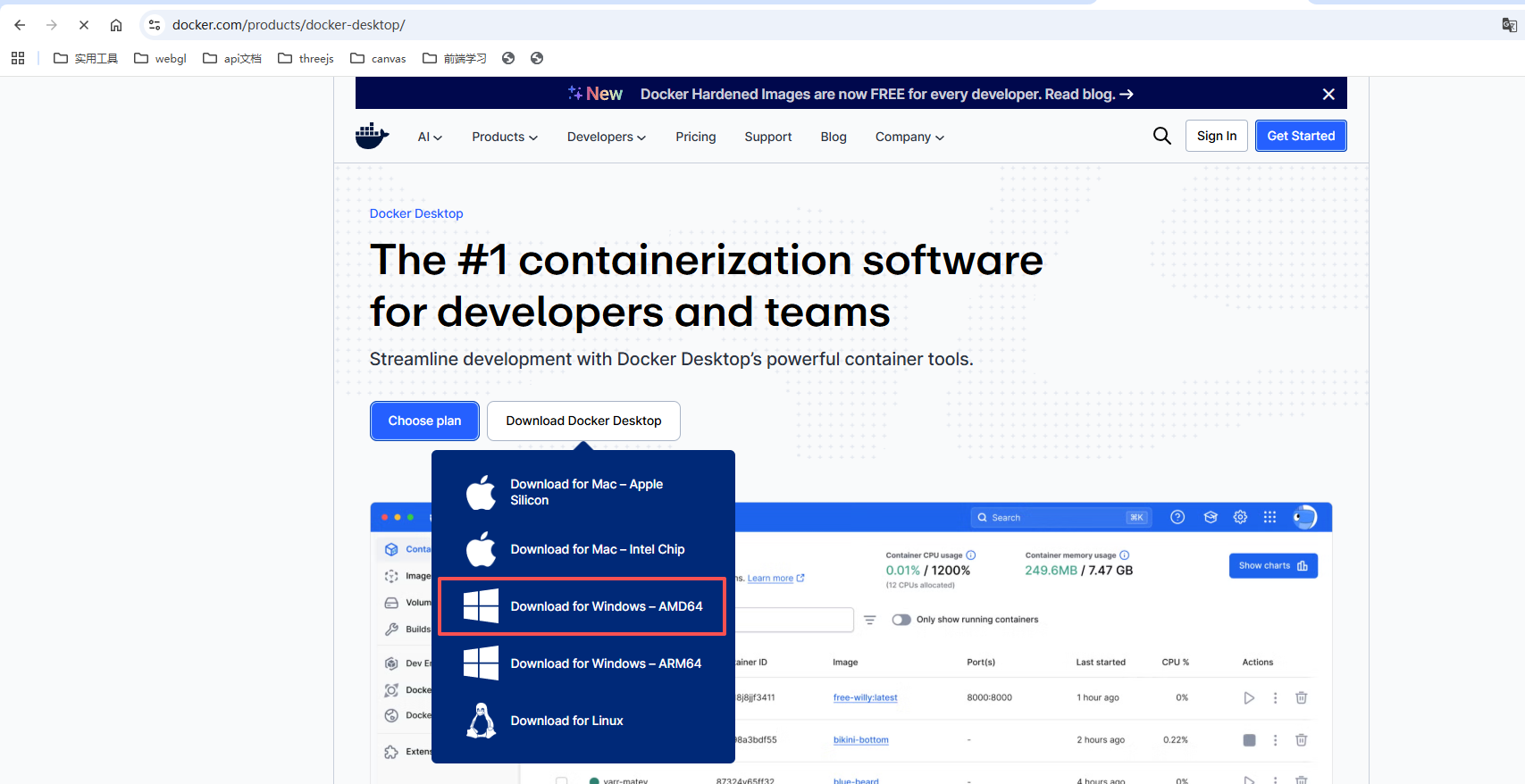

# 安装Docker

Docker是用来运行AnythingLLM的基础工具,就像一个“软件容器”,可以让我们不用操心复杂的环境配置。

https://www.docker.com/products/docker-desktop/ (opens new window)下载安装包

双击安装包开始安装,选择「Use WSL 2 instead of Hyper-V」(如果系统提示需要启用WSL,按照提示完成操作)

安装完成后,Docker会自动启动,你可以在任务栏右下角看到Docker的鲸鱼图标

打开Docker,进入配置页面,进入Docker Engine,将配置修改为,这一步是改为国内源

{

"debug": false,

"experimental": false,

"insecure-registries": null,

"registry-mirrors": [

"https://docker.m.daocloud.io",

"https://registry.docker-cn.com",

"https://hub-mirror.c.163.com",

"https://docker.mirrors.ustc.edu.cn"

]

}

2

3

4

5

6

7

8

9

10

11

点击Apply重启Docker

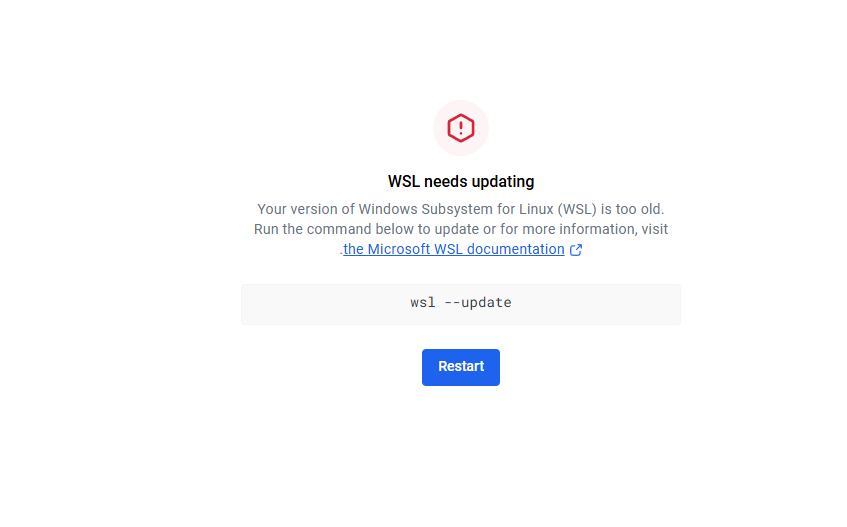

注意

如果打开docker的界面出现这个不要慌

解决方法:

- 启用适用于 Linux 的 Windows 子系统

必须先启用“适用于 Linux 的 Windows 子系统”可选功能,然后才能在 Windows 上安装任何 Linux 分发版。 以管理员身份打开 PowerShell (> PowerShell > 右键单击 > 以管理员身份运行) 并输入以下命令:

dism.exe /online /enable-feature /featurename:Microsoft-Windows-Subsystem-Linux /all /norestart

- 打开PowerShell(右键开始菜单选择Windows PowerShell),输入以下命令并回车:

wsl --update

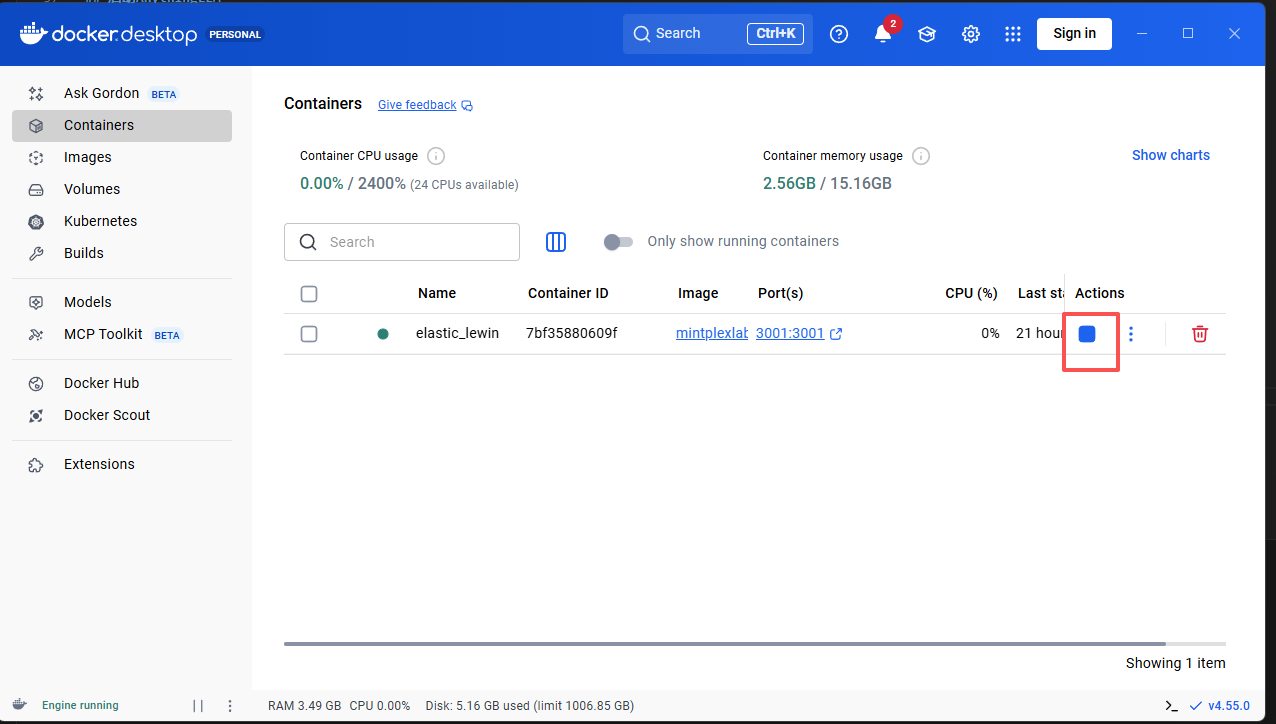

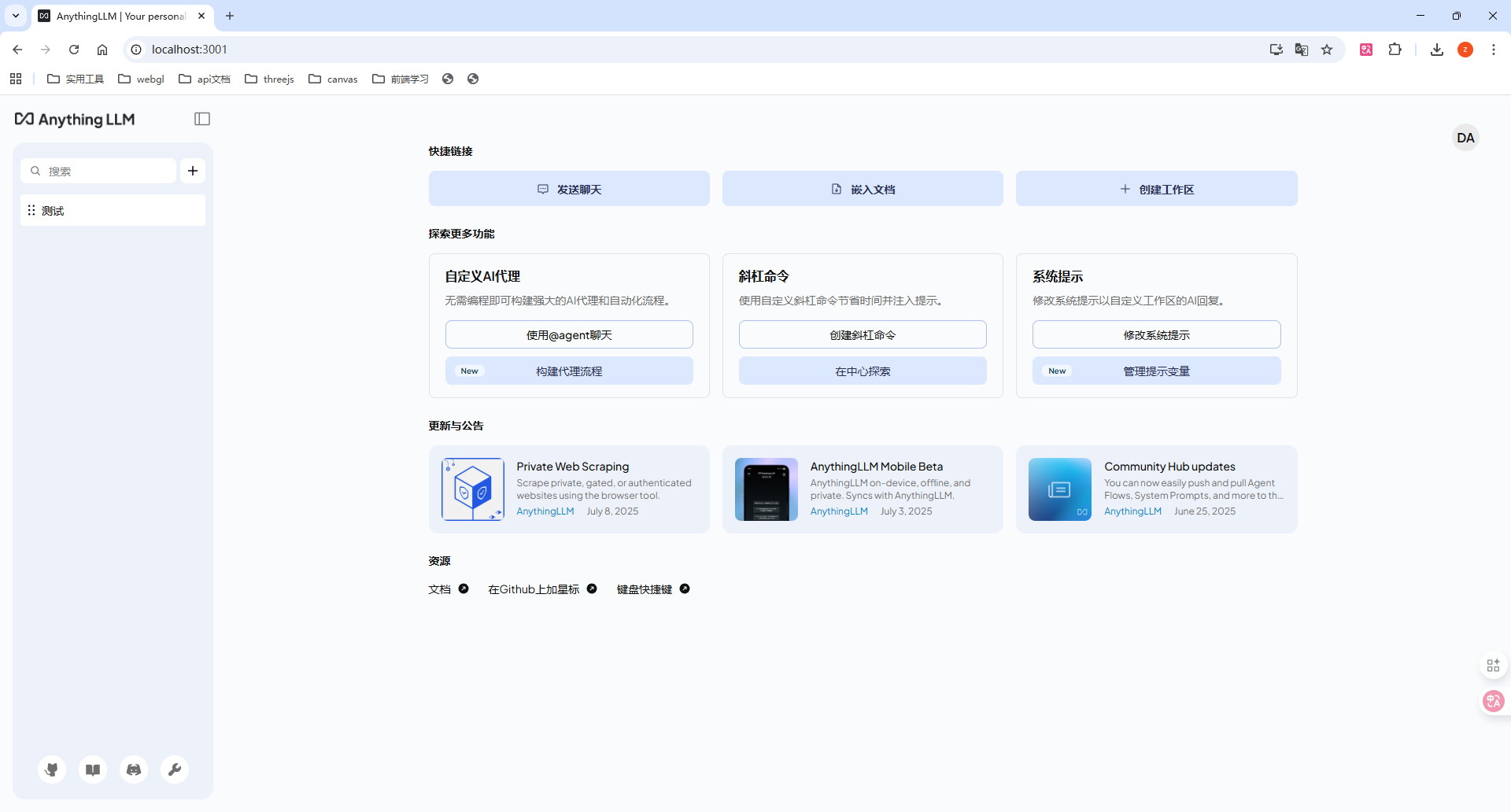

# 启动AnythingLLM (可选,体验一下,我们实际不用这个)

AnythingLLM开源免费的知识库管理工具,代码完全公开

- 拉取anythingllm镜像(我们不使用这个,当然你想用这个也行)

打开cmd, docker pull mintplexlabs/anythingllm

拉取完以后启动

docker run -p 3001:3001 -v D:/anythingllm:/app/server/storage -e STORAGE_DIR=/app/server/storage mintplexlabs/anythingllm

然后就可以在 localhost:3001访问到了

以后可以直接在docker里直接运行不用复杂的命令行

然后就可以看到成功运行了

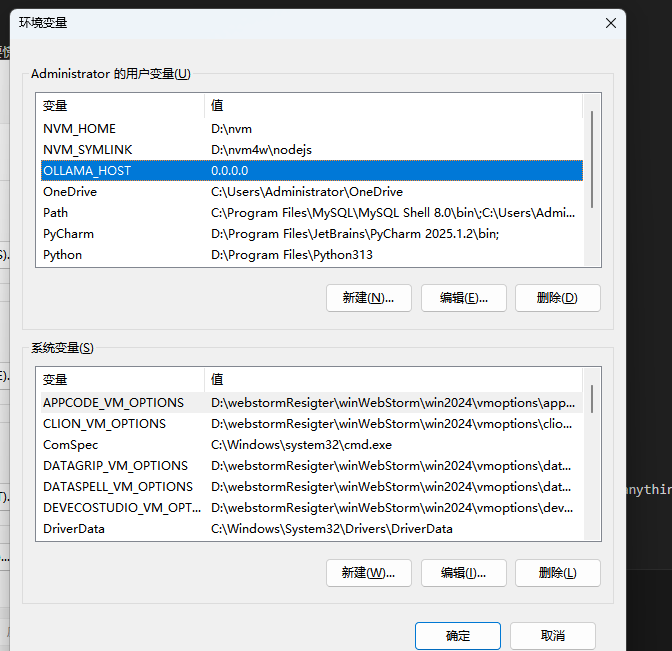

# 下载并启动RAGflow

- 配置Ollama环境变量

OLLAMA_HOST=0.0.0.0

- 访问Ollama的官方网站去查找自己想要的模型https://ollama.com/search (opens new window)

ollama pull qwen3-embedding:8b

ollama pull qwen3:8b

2

可以换成更好的模型

2. 下载RAGflow

https://github.com/infiniflow/ragflow/blob/main/README_zh.md (opens new window)

git clone https://github.com/infiniflow/ragflow.git

- 修改配置

下载好的ragflow文件夹下有个docker文件夹,里面有个.env配置,修改配置,将这一行的注释取消

RAGFLOW_IMAGE=infiniflow/ragflow:v0.23.0

- docker部署并启动

进入ragflow/docker文件夹下,cmd执行命令

docker compose -f docker-compose.yml up -d

提示

如果你遇到 Docker 镜像拉不下来的问题,可以在 docker/.env 文件内根据变量 RAGFLOW_IMAGE 的注释提示选择华为云或者阿里云的相应镜像。

华为云镜像名:swr.cn-north-4.myhuaweicloud.com/infiniflow/ragflow 阿里云镜像名:registry.cn-hangzhou.aliyuncs.com/infiniflow/ragflow

- 服务成功后确认一下服务器状态

docker logs -f docker-ragflow-cpu-1

出现以下界面提示说明服务器启动成功:

/ __ \ / | / ____// ____// /____ _ __

/ /_/ // /| | / / __ / /_ / // __ \| | /| / /

/ _, _// ___ |/ /_/ // __/ / // /_/ /| |/ |/ /

/_/ |_|/_/ |_|\____//_/ /_/ \____/ |__/|__/

* Running on all addresses (0.0.0.0)

2

3

4

5

6

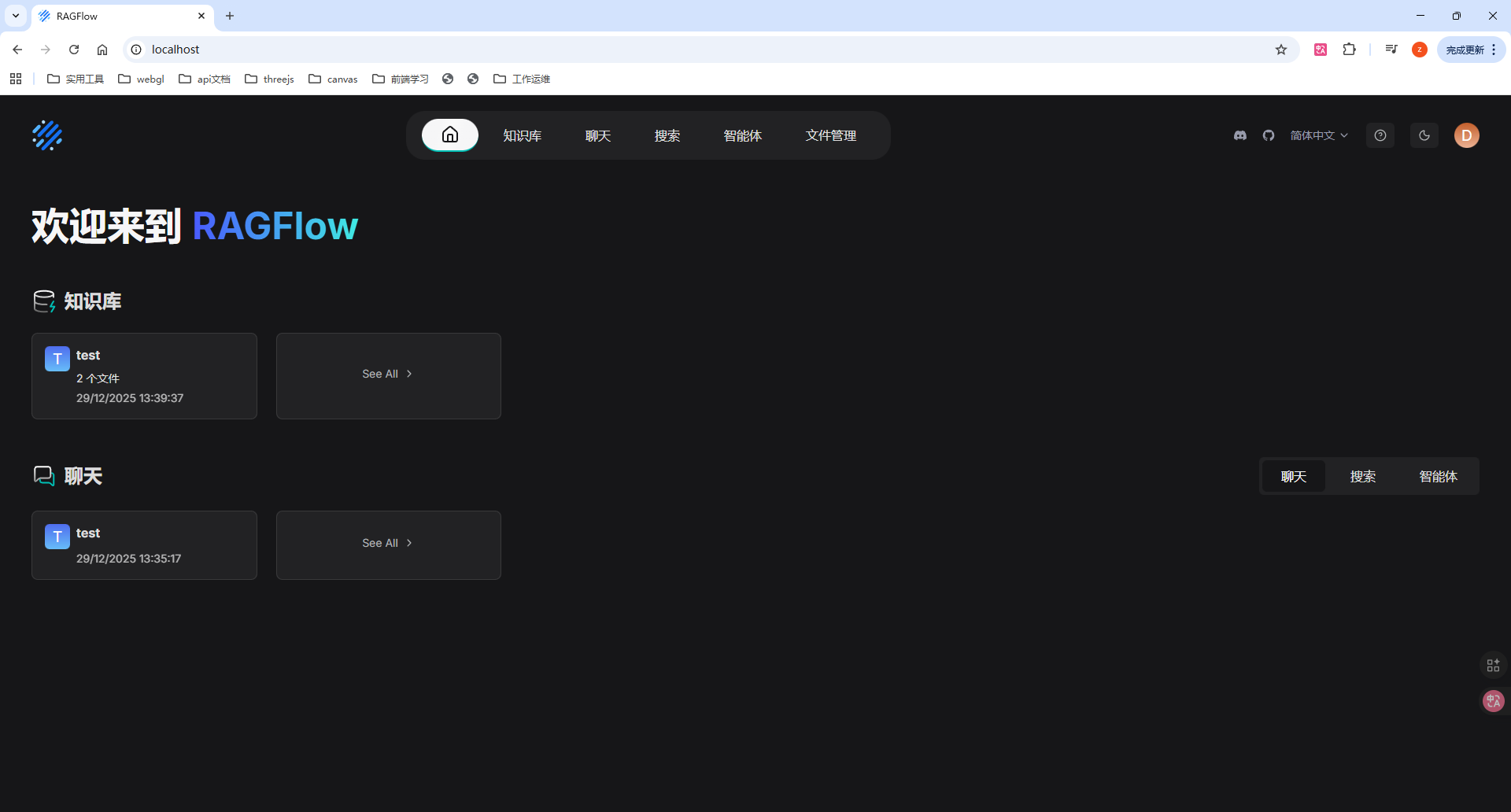

# 访问并配置RAGflow

直接在浏览器上访问localhost就可以访问你的RAGflow,第一次进来要注册登录,注册登录一下就好了

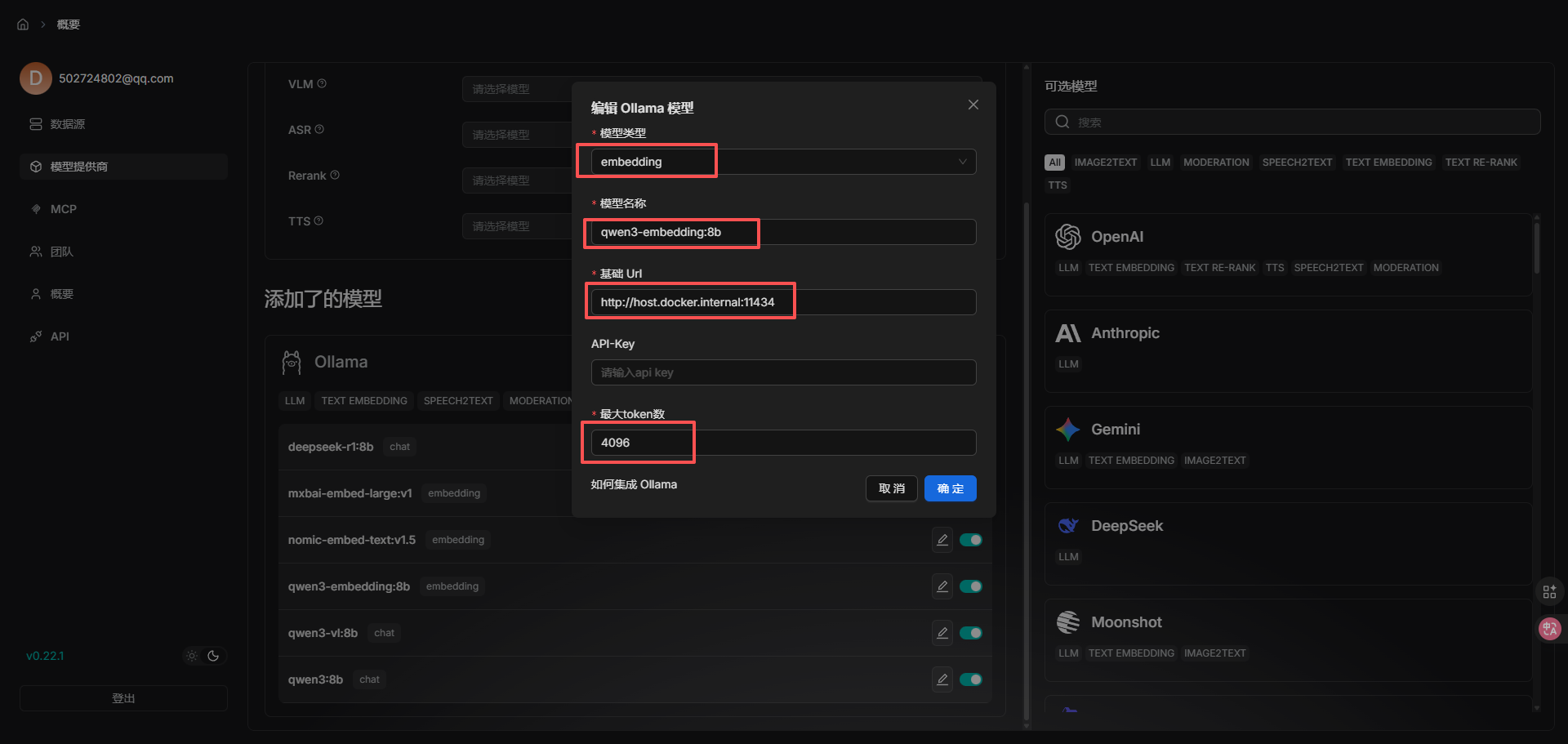

- 点击头像》模型提供商,添加模型,我们选择Ollama模型 有几点需要注意一下:

- 模型的类型是embedding还是chat需要选择

- 模型名称不能随便乱填,可以去命令行里Ollama list看一下有哪些模型,直接复制名字

- windows下用docker部署的,基础url需要填 http://host.docker.internal:11434,不然添加不上

- embedding模型和chat模型都需要添加至少一个

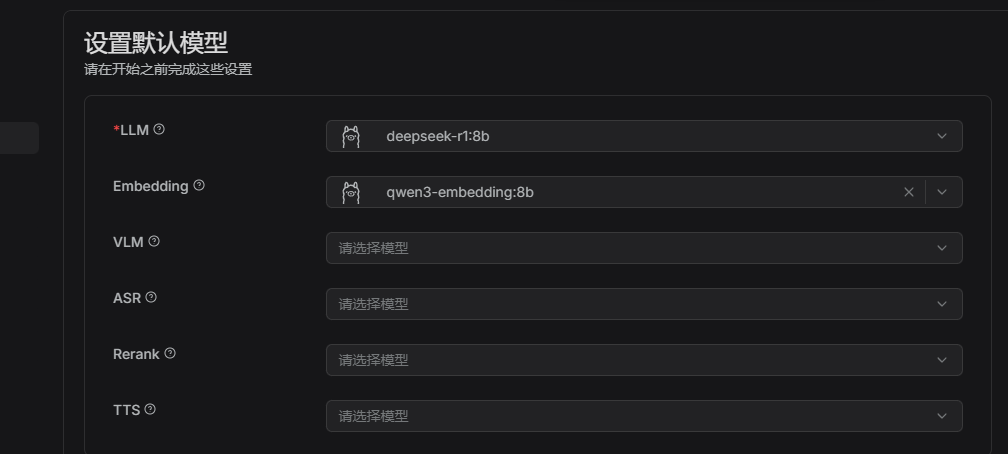

- 设置默认模型,这里选择就行了

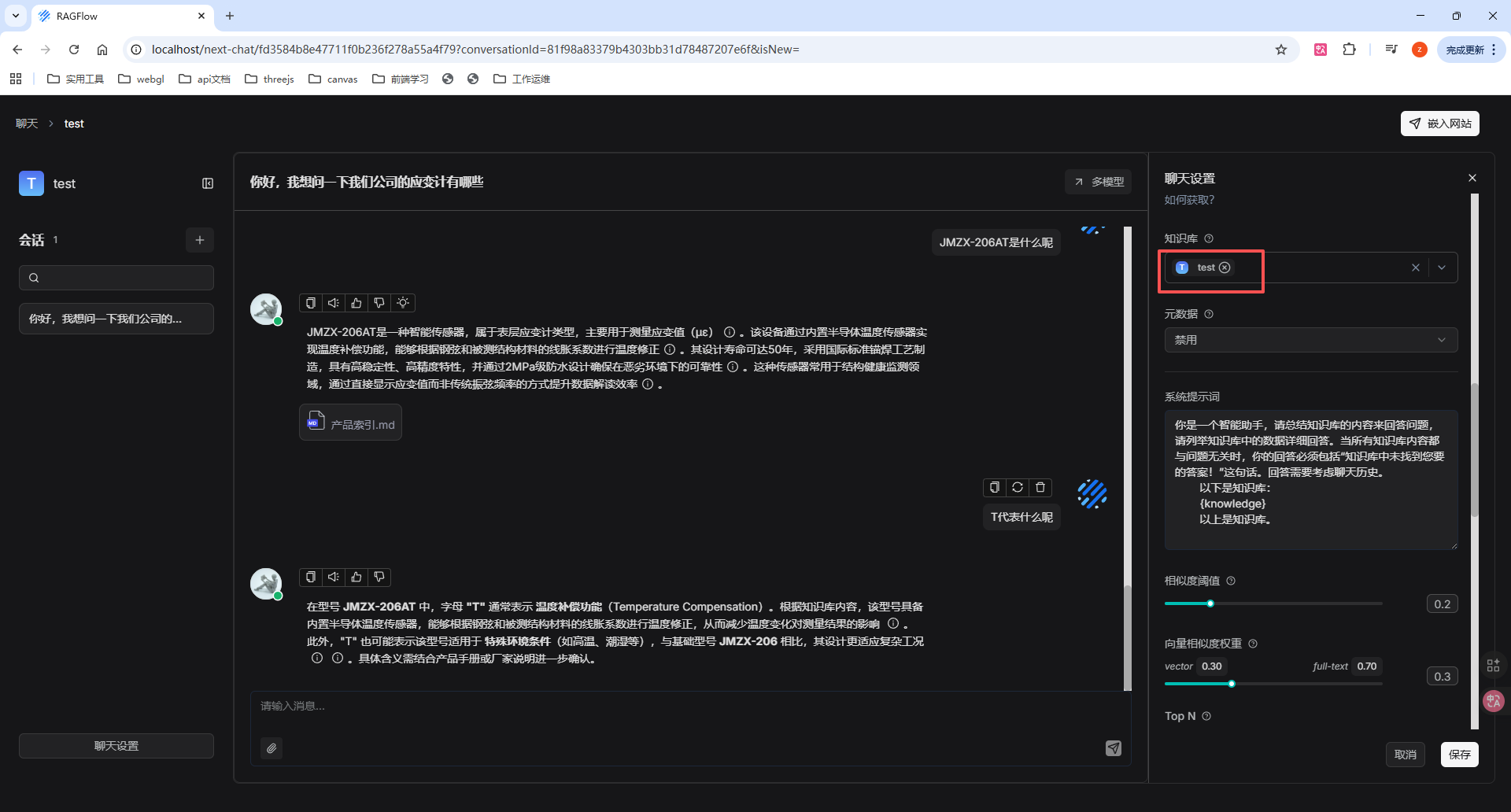

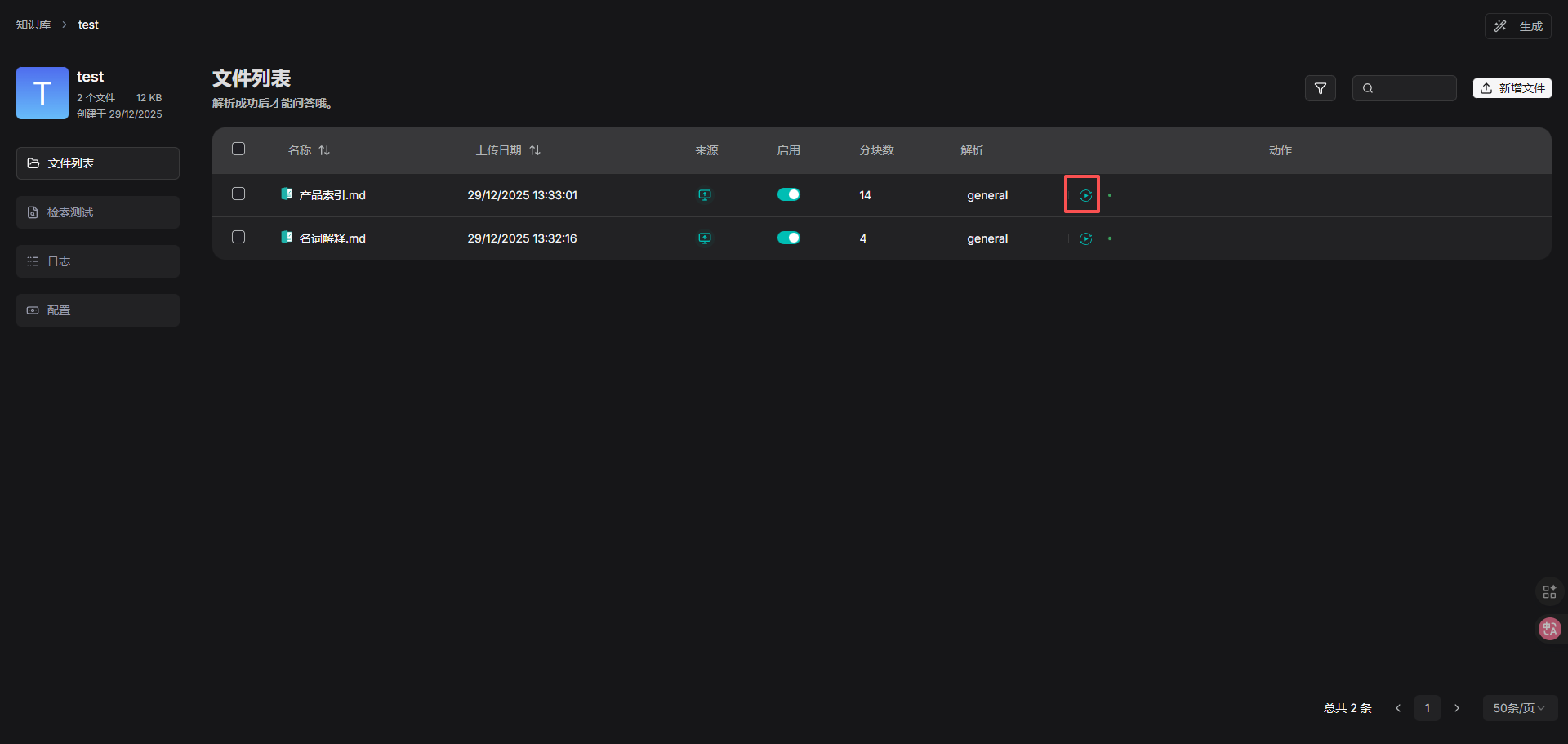

# 上传文件构建知识库

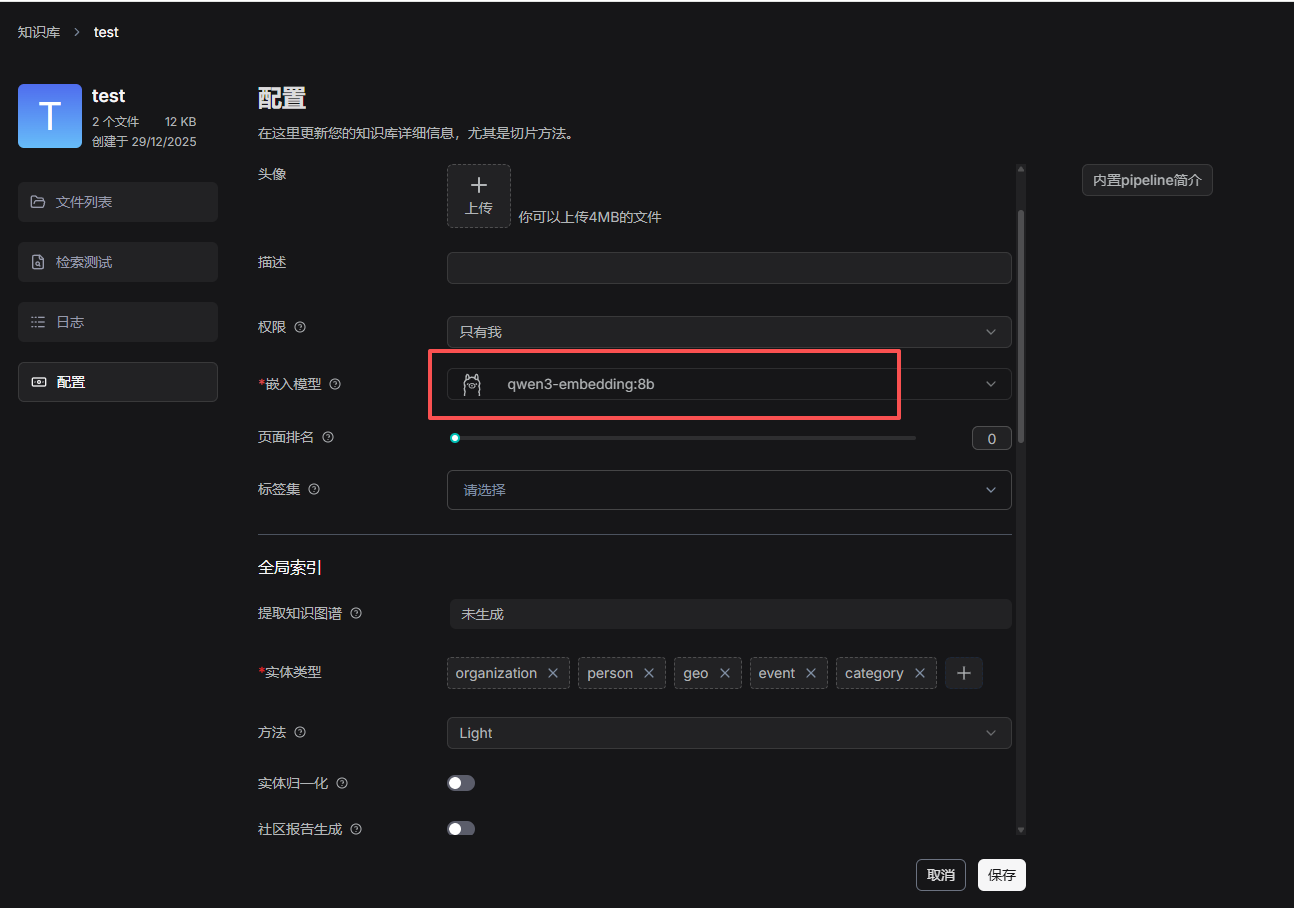

新建一个知识库,点击配置

- 需要选嵌入模型,在你的电脑承受的范围内选最好的

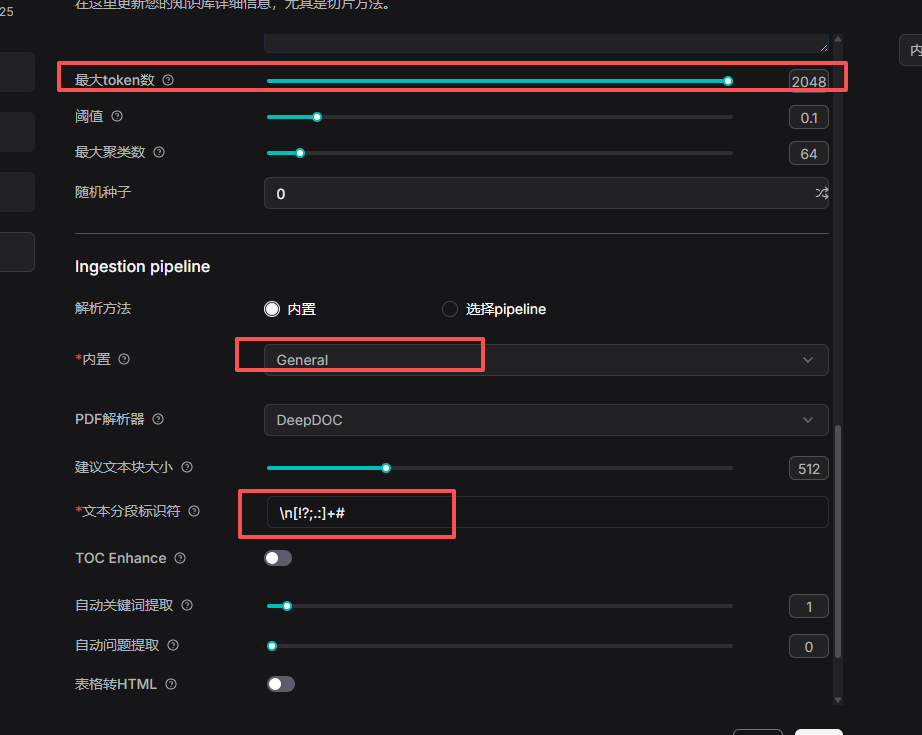

- 最大token数调大

- 内置分块的方法选General

- 文本分段标识符填一下,然后保存

上传文件然后点击解析

然后新建一个聊天,配置聊天的知识库和模型,就可以正常对话啦,问知识库中的内容没有问题